英伟达发布首个世界基础模型,对英伟达的市场地位有何影响?

大模型(LLM)是一种人工智能模型,旨在理解和生成人类语言。它们在大量的文本数据上进行训练,可以执行广泛的任务,包括文本总结、翻译、情感分析等等。LLM的特点是规模庞大,包含数十亿的参数,帮助它们学习语言数据中的复杂模式。这些模型通常基于深度学习架构,如转化器,这有助于它们在各种NLP任务上取得令人印象深刻的表现。

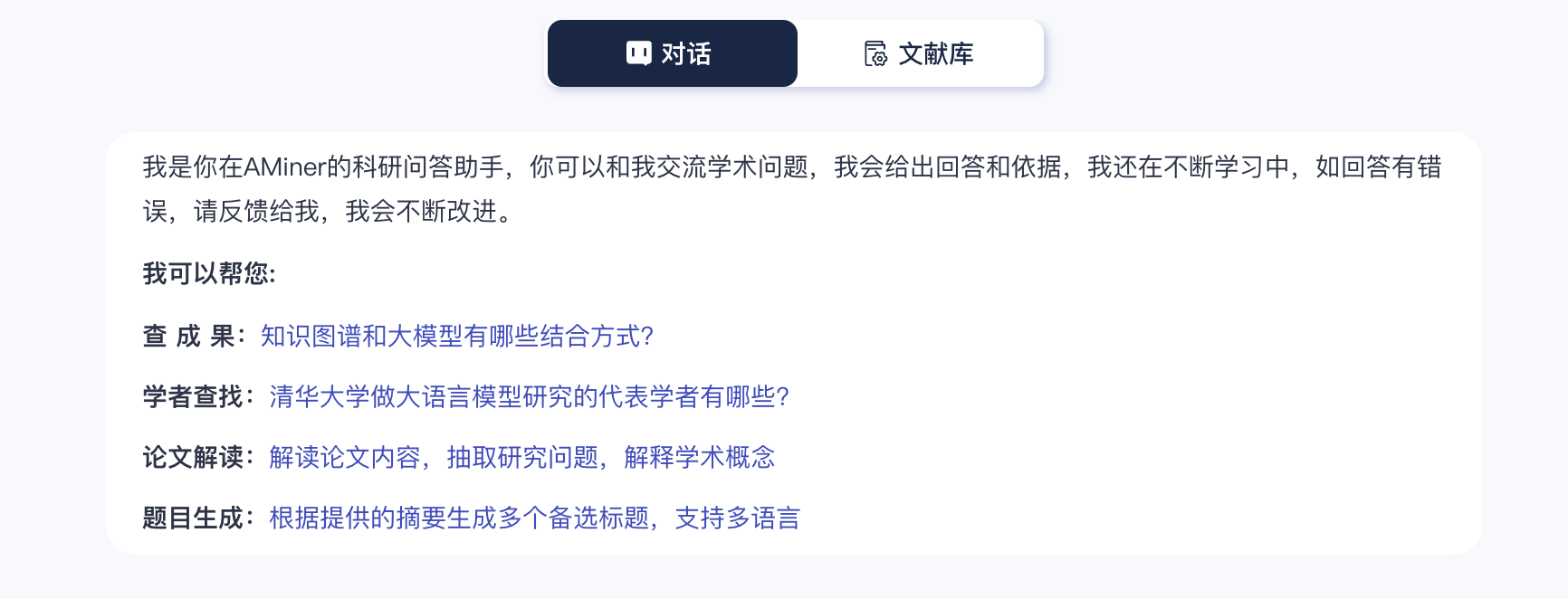

本周大模型周报整理了7篇论文,详细可查看专题:https://www.aminer.cn/topic/67862708551679109f291eb3

75页报告,英伟达发布「世界基础模型」,用AI数据训练AI算法丨大模型周报 - 必读论文 - AMiner

为了方便大家阅读,只列出了论文标题、AMiner AI综述等信息,如果感兴趣可点击查看原文,PC端数据同步(收藏即可在PC端查看),每日新论文也可登录小程序查看。

如果想要对某篇论文进行深入对话,可以直接复制论文链接到浏览器上或者直达AMiner AI页面:

https://www.aminer.cn/chat/g/explainTransPixar: Advancing Text-to-Video Generation with Transparency

【要点】:本文提出了一种名为TransPixar的方法,通过扩展预训练的视频模型以生成包含透明度通道(RGBA)的视频,增强了视觉效果和交互式内容创作的可能性。

【方法】:TransPixar采用扩散变换器(DiT)架构,并引入了针对透明度通道的特定标记,同时使用LoRA-based微调技术,以实现RGB和透明度通道的高一致性生成。

【实验】:研究团队在特定数据集上对TransPixar进行了训练和评估,证明了该方法能够生成多样且一致性的RGBA视频,同时保持了与原始RGB模型的优势和RGB与透明度通道之间的高度一致。

【链接】:https://www.aminer.cn/pub/677c9894ae8580e7ff366ffa

Cosmos World Foundation Model Platform for Physical AI

【要点】:本文介绍了Cosmos World Foundation Model Platform,一种开放源代码的通用世界模型平台,旨在帮助开发者为其物理AI系统构建定制化的世界模型,解决社会关键问题。

【方法】:平台包括视频编辑流程、预训练的世界基础模型、预训练模型的后训练示例以及视频分词器,提供了一套完整的工具和方法来构建和微调世界模型。

【实验】:论文未具体描述实验过程,但提供了通过GitHub(https://github.com/NVIDIA/Cosmos)开放的预训练模型和工具,以便开发者使用和微调。

【链接】:https://www.aminer.cn/pub/677de685ae8580e7ff3588ee

LLM-Powered GUI Agents in Phone Automation: Surveying Progress and Prospects

【要点】:本文系统回顾了大型语言模型(LLM)驱动的手机GUI代理的发展,展示了其从基于脚本的自动化到智能自适应系统的转变,并提出了当前面临的挑战和研究方向。

【方法】:作者构建了一个分类法,涵盖基本的代理框架(单一代理、多代理、计划后执行)、建模方法(提示工程、基于训练的方法)以及关键数据集和基准。

【实验】:论文详细讨论了特定任务架构、监督微调和强化学习策略,以连接用户意图和GUI操作,但未具体提及使用的实验数据集名称和结果。

【链接】:https://www.aminer.cn/pub/677f8d97ae8580e7fff773a8

ParGo: Bridging Vision-Language with Partial and Global Views

【要点】:本研究提出了一种名为ParGo的新型部分-全局投影器,通过整合全局和部分视角,有效连接视觉和语言模态,提升多模态大型语言模型(MLLMs)的性能。

【方法】:ParGo通过融合全局和部分视角,缓解了对显著区域的过度关注,从而减少视觉编码器与LLMs之间的表征差距。

【实验】:作者收集了一个大规模的细粒度标注图像-文本数据集ParGoCap-1M-PT,包含100万对图像和高质量字幕。在多个MLLM基准测试上的广泛实验表明ParGo的有效性,相比传统的Q-Former投影器,在MME基准上提高了259.96分。此外,ParGo在强调细节感知能力的任务上显著优于其他投影器。

【链接】:https://www.aminer.cn/pub/66cbe07901d2a3fbfc59660c

rStar-Math: Small LLMs Can Master Math Reasoning with Self-Evolved Deep Thinking

【要点】:本文提出rStar-Math模型,通过自我进化的深度思考机制,实现了小型语言模型在数学推理能力上媲美甚至超越OpenAI o1的表现。

【方法】:rStar-Math采用蒙特卡洛树搜索(MCTS)进行“深度思考”,并结合两个小型语言模型(SLM)——一个执行数学策略的SLM和一个基于SLM的过程奖励模型(PPM)。

【实验】:通过四轮自我进化,生成数百万个合成解决方案用于训练747k个数学问题的数据集,rStar-Math在MATH基准测试中,将Qwen2.5-Math-7B的表现从58.8提升至86.4(AIME),平均解决了53.3%的问题,具体数据和代码可在https://github.com/microsoft/rStar找到。

【链接】:https://www.aminer.cn/pub/677f38a4ae8580e7ff232812

The GAN is Dead; Long Live the GAN! A Modern GAN Baseline

【要点】:本文提出了一个新的生成对抗网络(GAN)基准模型R3GAN,通过改进GAN损失函数并采用现代网络架构,有效解决了传统GAN训练中的模式崩溃和收敛性问题,实现了优于现有先进GAN和扩散模型的性能。

【方法】:作者推导了一种表现良好的正则化相对GAN损失函数,并从数学上分析了该损失函数,证明了其具有局部收敛性保证。

【实验】:通过在FFHQ、ImageNet、CIFAR和Stacked MNIST数据集上的实验,证明了R3GAN的性能优于StyleGAN2和其他先进GAN及扩散模型。

【链接】:https://www.aminer.cn/pub/6756a611ae8580e7ff9d9016

Towards System 2 Reasoning in LLMs: Learning How to Think With Meta Chain-of-Thought

【要点】:本文提出了一种名为Meta Chain-of-Thought (Meta-CoT)的框架,通过显式建模传统Chain-of-Thought (CoT)背后的推理过程,增强了大型语言模型(LLM)的推理能力,实现了更接近人类思维的推理。

【方法】:通过过程监督、合成数据生成和搜索算法,作者开发了一种训练模型生成Meta-CoT的方法,并采用了指令微调与线性化搜索轨迹以及强化学习后训练。

【实验】:作者未具体描述实验细节,但提及了使用状态-of-the-art模型进行行为验证,并讨论了训练模型生成Meta-CoT的流程,具体数据集名称未提及。结果显示,该方法有助于提升模型的推理能力,并探讨了潜在的推理算法发现。

【链接】:https://www.aminer.cn/pub/677f3847ae8580e7ff220028